用dify的多模型调试功能,对比了新版DeepSeek V3和旧版DeepSeek V3的知识库问答效果,发现使用新版效果提升非常明显!接下来我带大家在dify接入新版deepseek v3,并看下实测效果。而openrouter真滴卷,deepseek昨天才开源的新版deepseek v3,它立马就上线了(关键api还是免费使用)。甚至连deepseek官网都没有通知,我都不知道deepseek官方api到底有没有更新到新版v3,而且就算更新了,估计调用的人也很多,到时候可能又会卡

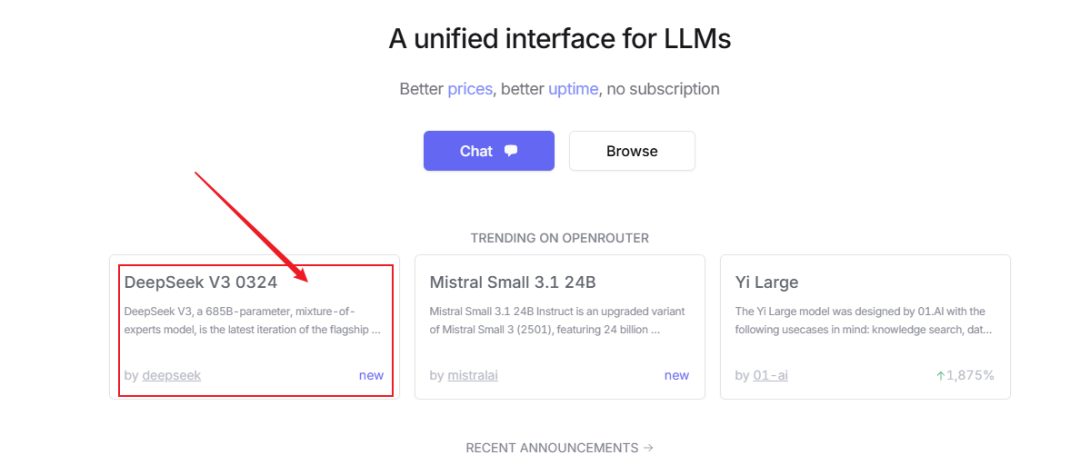

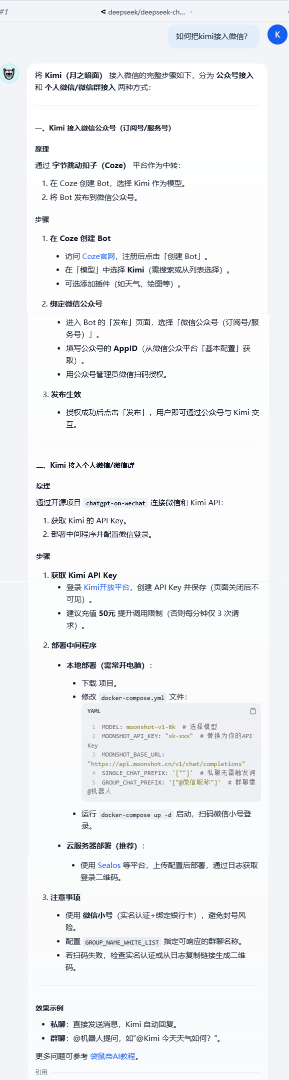

访问openrouter,首页就能看到新版V3,点击进入模型名称:deepseek/deepseek-chat-v3-0324:freehttps://openrouter.ai/api/v1因为是调用github,可能会有点慢,或者失败,多试几次即可

在安装好的供应商列表找到openrouter,点击设置把openrouter的apikey粘贴到下图位置,保存这里会自动读取相关模型,但是自动读取到的模型里面并没有新版deepseek v3,所以我们需要额外添加接下来,我直接用上次测试minimax-01的知识库来对新版deepseek v3进行测试。感兴趣的朋友可以看下之前这篇:使用了不同的方式构建知识库,并且当你的知识库内容非常庞大的时候,更适合用minimax-01

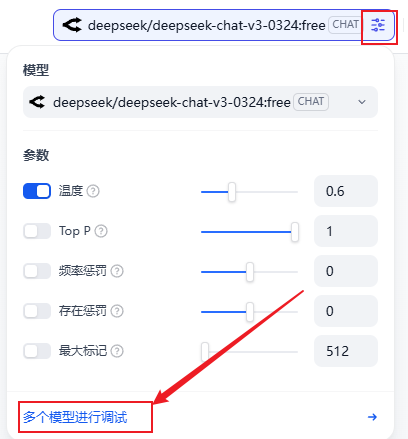

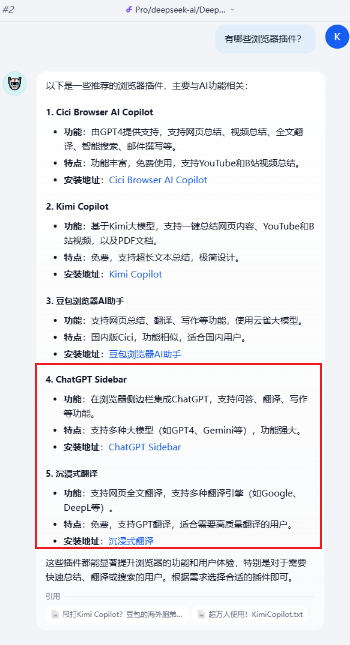

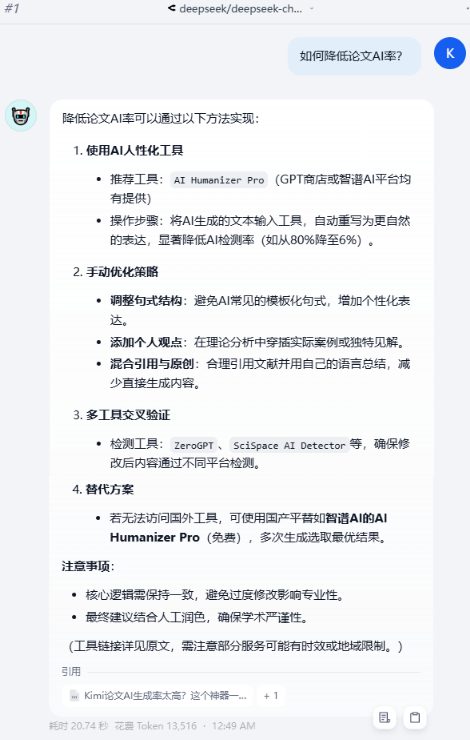

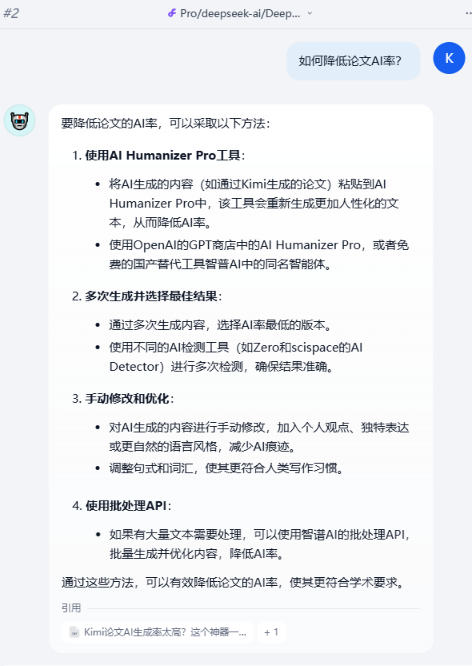

在bot的编辑页面,点击模型参数配置->多个模型进行调试这里我开了两个模型,一个是刚刚配置的openrouter的新版v3,一个是硅基流动的旧版v3这时,我在输入框发送一个问题,两边就会同时执行,用来测试不同模型的效果非常方便、直观。从上面第一个问题可以看出,虽然两边都回答正确,但是新版v3更详细。回答的内容都正确,但还是新版V3更详细(左边新版V3,右边旧版V3)我知识库里面提到的插件就只有豆包(海外cici、和国内版),以及kimi Copilot。旧版V3还是容易出现幻觉,回答内容里面凭空出现了沉浸式翻译、和ChatGPT sidebar,,,而新版V3这边回答正确,还给出了一个表格进行对比,以及贴心的推荐了使用场景,这就是上下文长度和理解能力增强的表现。知识库中提到了两种,一种是海外Humanizer Pro,一种是智谱的Humanizer Pro,新版V3两种都提到了,而旧版V3缺少了智谱的Humanizer Pro。实测下来,真的新版DeepSeek V3,提升不止亿点点:上下文理解能力显著增强,回复更加详细,不容易出现幻觉,prompt理解能力增强,更加遵守prompt。经过多次测试,发现回复的内容,习惯性的会增加表格,进行对比(这点太贴心了)所以,现在新版DeepSeek V3应该是目前最具性价比的大模型了。各方面能力都直逼Claude3.7,但API甚至还能免费用。不过openrouter的新版deepseek v3接口有点不太稳,偶尔会卡住几秒到几十秒才继续回复,生产环境建议等火山、硅基流动等接入之后在切换

总结一下,如果您的知识库数量非常庞大,推荐使用minimax-01(因为它有最长上下文-400万tokens,而且比deepseek API还便宜)如果您的知识库数据量一般,推荐直接上新版DeepSeek V3。这个数据量多大 算庞大呢?不好说,可以两个都使用,对比一下效果就知道选谁了。